吉他搖滾、電子音樂都能搞定,Meta開源音訊生成新模型MAGNeT,非自回歸7倍加速

在文字生成音訊(或音樂)這個AIGC 賽道,Meta 最近又有了新研究成果,而且開源了。

前幾日,在論文《Masked Audio Generation using a Single Non-Autoregressive Transformer》中,Meta FAIR 團隊、Kyutai 和希伯來大學推出了MAGNeT,一種在掩碼生成序列建模方法,可以直接在多個音訊tokens 流上直接運行。與以往工作最大的不同是,MAGNeT 是由單階段、非自回歸transformer 產生音訊。

- 論文網址:https://arxiv.org/pdf/2401.04577.pdf

- GitHub 網址:https://github.com/facebookresearch/audiocraft/blob/main/docs/MAGNET.md

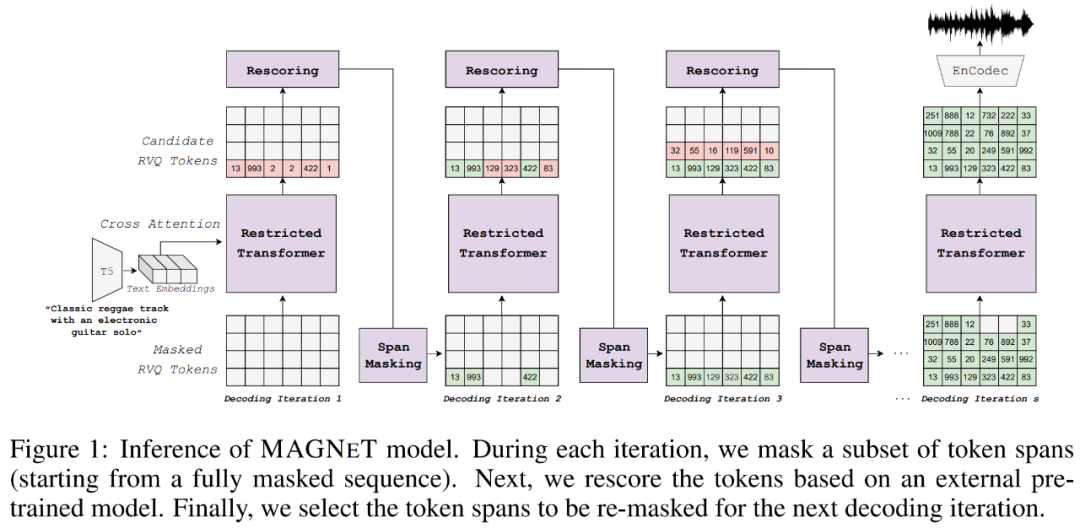

具體來講,在訓練期間,研究者預測從掩碼調度器獲得的掩碼token 的範圍;在模型推理階段, 則透過幾個解碼步驟逐漸建立輸出序列。為了進一步增強生成音訊質量,他們提出一種新穎的重評分方法,利用外部預訓練模型對來自MAGNET 的預測進行重評分和排名,然後用於後續的解碼步驟。

此外,研究者也探討了MAGNET 的混合版本,融合自迴歸和非自迴歸模型,以自迴歸的方式產生前幾秒,同時對剩餘序列進行並行解碼。

從生成結果來看,MAGNET 在文字到音訊和文字到音樂任務上取得了非常不錯的效果,品質媲美SOTA 自回歸基線模型的同時速度是它們的7 倍。

大家可以聽聽產生的音樂效果。

MAGNeT 方法概覽

下圖1 為MAGNeT 原理圖,作為一個非自回歸的音訊產生掩碼語言模型,它以條件語意表示為條件,在從EnCodec 中獲得的幾個離散音頻token 流上運行。在建模策略上,研究者進行了包含掩碼策略、受限上下文、取樣機制和模型重評分等幾個方面的核心建模修改。

首先來看掩碼策略,研究者評估了20ms 到200ms 之間的各種跨度長度,並發現60ms 跨度長度可以提供最佳的整體性能。他們從調度器中採樣了掩碼率γ(i),並相應地計算了進行掩碼的平均跨度量。此外從計算效率方面考慮,研究者也使用了非重疊跨度。

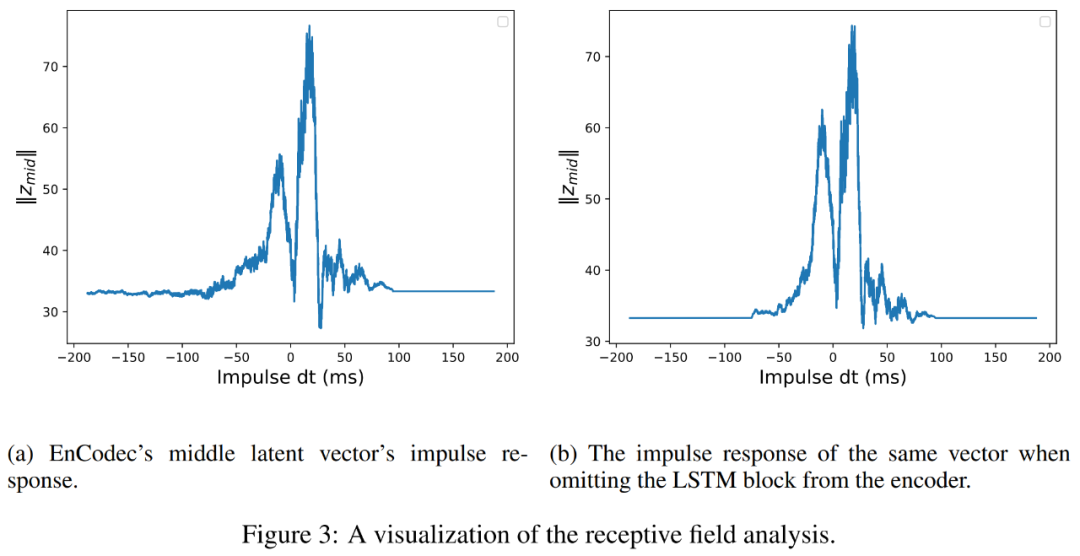

接著是受限上下文。研究者使用到了EnCodec 並相應地限制了碼本的上下文。具體來講,音訊編碼器由多層卷積網路和最終的 LSTM 區塊組成。 EnCodec 感受野的分析結果表明,卷積網絡的感受野約為160ms,而包含LSTM 塊的有效感受野約為180ms。研究者使用隨時間推移的平移脈衝函數並測量了序列中間編碼向量的幅度,進而對模型的感受野進行了實證評估。

下圖3 為過程展示,不過LSTM 儘管在理論上具有無限記憶,但實際觀察來看是有限的。

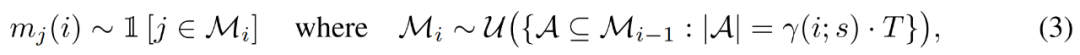

最後是模態推理,包含取樣和無分類器指導退火。取樣如下公式(3)所示,使用均勻取樣從先前一組遮罩跨距中選擇跨距。在實踐中,研究者使用第i 次迭代時的模型置信度作為評分函數,來對所有可能的跨度進行排序,並相應地選擇最不可能進行掩碼的跨度。

對於token 預測,研究者選擇使用無分類器指導來完成。在訓練期間,他們有條件和無條件地對模型進行最佳化;在推理期間,他們從獲得自條件和無條件機率的線性組合的一個分佈中進行採樣。

實驗及結果

在實驗環節,研究者在文字到音樂生成和文字到音訊生成任務上對MAGNeT 進行評估。他們使用了與Copet et al. (2023) 所用完全相同的音樂產生訓練數據,與Kreuk et al. (2022a) 所用完全相同的音頻生成訓練數據。

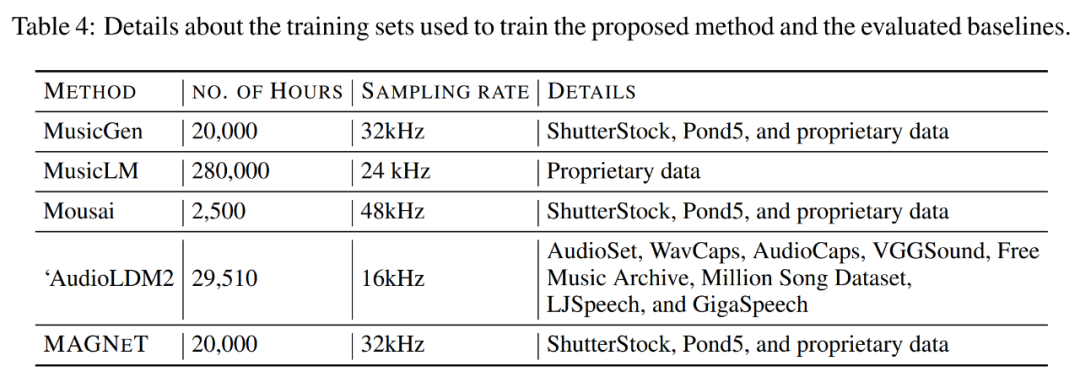

下表4 展示了用於訓練MAGNeT 以及其他基準方法(包括MusicGen、MusicLM 和AudioLDM2)的訓練集細節。

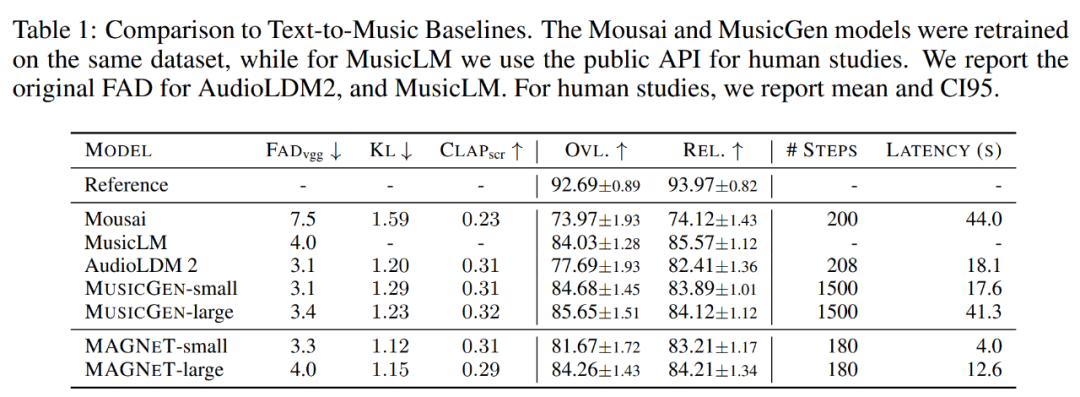

下表1 為MAGNeT 在文字到音樂生成任務上與其他基線方法的比較結果,所使用的評估資料集為MusicCaps。我們可以看到,MAGNeT 的表現與使用自回歸建模方法的 MusicGen 相當,但在生成速度(延遲)和解碼兩方面比後者快得多。

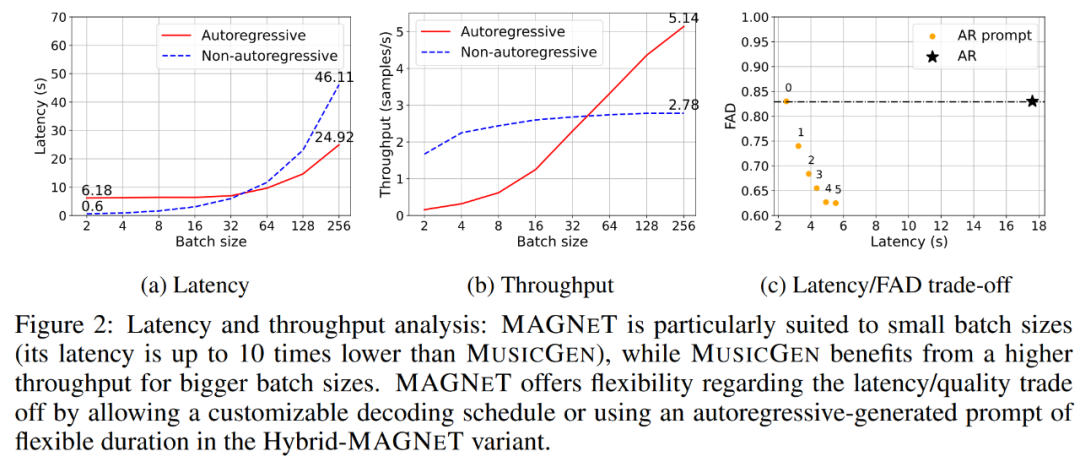

下圖2a 表明,與自回歸基線模型(紅色曲線)相比,非自回歸模型(藍色虛線)得益於並行解碼在小批大小時表現尤為出色,單個生成樣本的延遲低至600ms,是自迴歸基線模型的1/10。可以預見,MAGNeT 在需要低延遲預處理的互動式應用程式中應用潛力很大。此外在批次大小達到64 之前,非自迴歸模型產生速度都要比基線模型快。

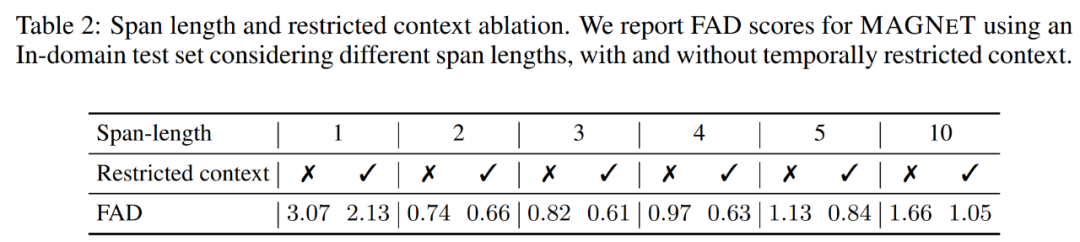

下表2 展示了跨度長度和受限上下文的消融實驗。研究者報告了使用域內測試集時,MAGNeT 在不同跨度長度、有無時間受限上下文情況下的FAD(Fréchet Audio Distance)分數。

更多技術細節和實驗結果請參閱原論文。