DeepSeek本地部署教程,小白也能搞定!

安裝環境

操作系統:Windows 10及以上

準備工具:

- 輕量級AI模型調用工具Ollama,調用AI模型為deepseek-r1

- AI 模型管理工具Cherry-Studio或AnythingLLM(二選一)

資源連結:

https://pan.baidu.com/s/1RVWsJPRdPubjB9ppBTh4Bg

提取码:xyj1- 1.

- 2.

安裝步驟

第一步、下載安裝Ollama並修改環境變數

要運行大模型,首先需要一個好用的工具,推薦使用 Ollama ,它是一個輕量級的工具,支援快速安裝和運行大語言模型(如deepseek、Llama、Qwen 等)。

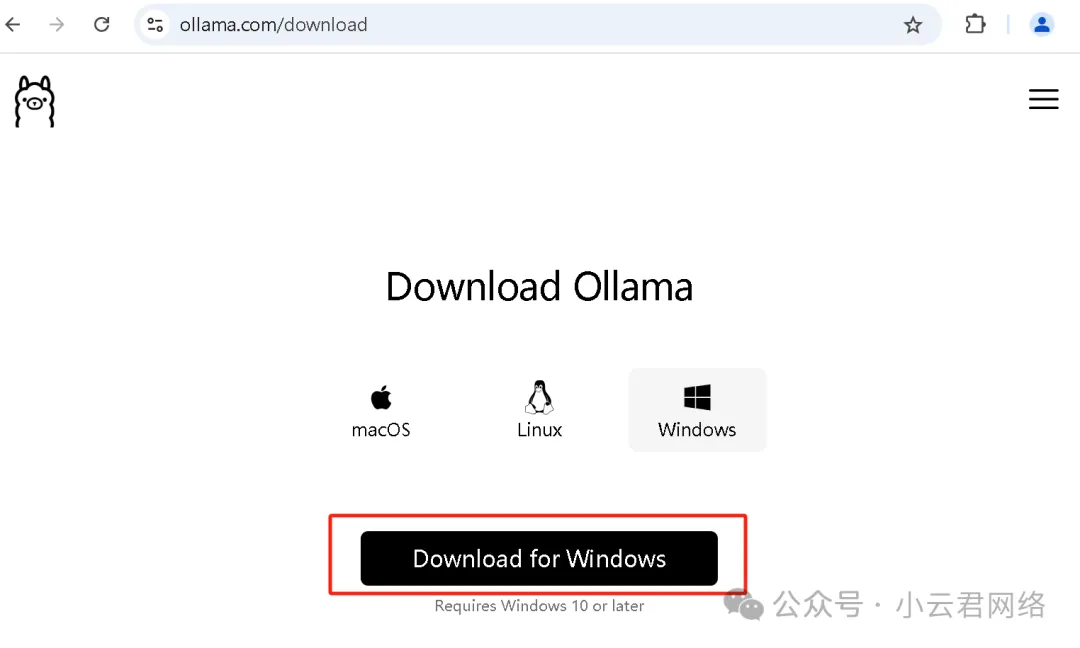

ollama 下載位址 :官網連結 https://ollama.com/download/ 或者我的網盤(文章開頭)

選擇合適的操作系統下載,預設安裝完成即可。 這裡注意,ollama安裝完成後先不要啟用,因為它預設是會將模型下載到C盤的,deepseek、Qwen等模型最小也有好幾個GB會佔用C盤空間,所以需要先設置ollama的環境變數。

環境變數設定方法:

(1) 功能表鍵搜索“環境變數”

(2) 按照如下步驟設置環境變數:

OLLAMA_HOST: 0.0.0.0

OLLAMA_MODELS:D:\Ollama model- 1.

- 2.

- OLLAMA_HOST:設置為0.0.0.0 會將ollama服務應用到所有的網路,默認ollama只綁定到了127.0.0.1和localhost上了;

- OLLAMA_MODELS_PATH:設置了AI模型的存放路徑。

(3)安裝ollama並且設置完環境變數后,CMD打開命令窗口輸入下述命令即可查看版本:

ollama -v- 1.

第二步、載入AI大模型(這裡使用deepseek-R1大模型)

(1) 打開ollama官網 https://ollama.com/search 可以找到AI大模型deepseek-r1,因為爆火,頭個就是它

進入後可根據自身電腦的配置選擇規格,然後複製後邊對應的命令即可

這裡說明一下:只有671B是滿血deepseek大模型,其它的都是蒸餾小模型。 另外根據自身電腦配置選擇規格參考如下(配置太低是跑不動高規格模型的)

模型 | 顯存需求 | 記憶體需求 | 推薦顯卡 | 性價比方案 |

7B | 10-12GB | 16GB | RTX 3060 | 二手2060S |

14B | 20-24GB | 32GB | RTX 3090 | 雙卡2080Ti |

32B | 40-48GB | 64GB | RTX 4090 | 租賃雲伺服器 |

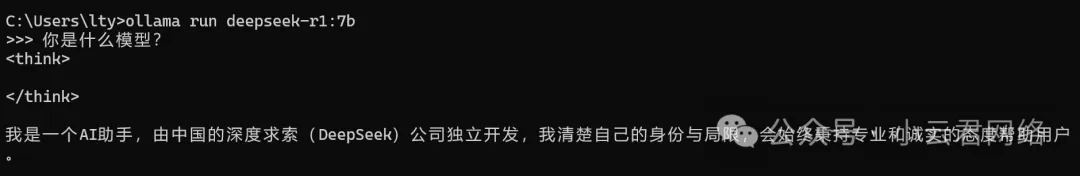

(2) 將剛剛複製的命令在CMD命令視窗中運行,即可完成AI模型下載(由於修改了環境變數,存放路徑不再是C盤):

ollama run deepseek-r1:7b- 1.

然後就可以提問AI了:

按Ctrl+Z可以回到上級,輸入以下命令可以查看已下載的模型清單:

ollama list- 1.

為了更加美觀和可視化的與AI交流,下面需要通過交互工具實現,可以用cherry-studio或者anythingLLM,二選一。 本文即介紹anythingLLM的部署方法。

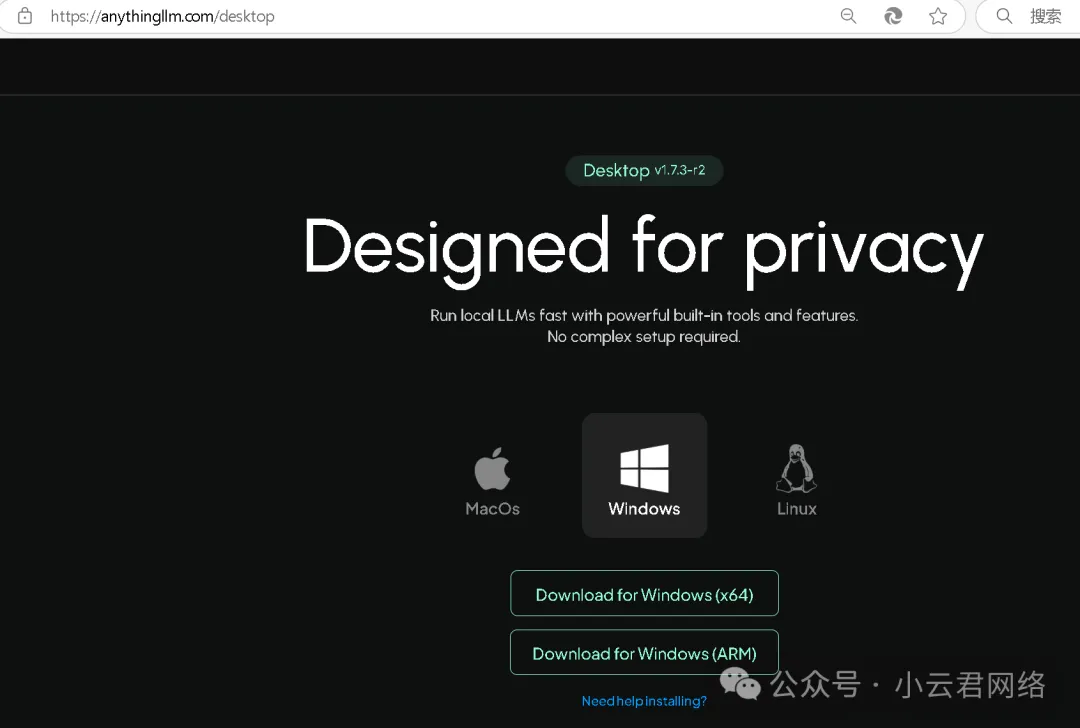

第三步、安裝AnythingLLM並通過ollama載入deepseek模型

(1) 下載位址:官網連結 https://anythingllm.com/desktop 或我的網盤(文章開頭)

(2) 完成安裝後打開AnythingLLM,點擊「設置」修改變量參數:

設置完成後創建自己的工作區,這樣就可以可視化的開展頁面對話了: